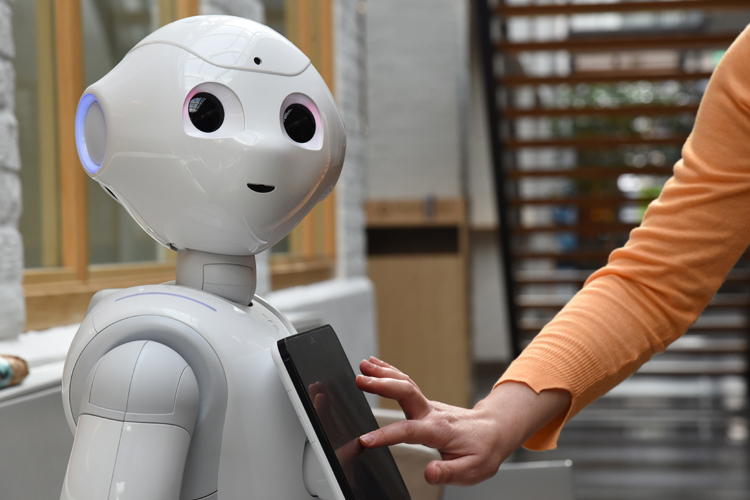

Artificiell intelligens, AI, kan redan idag sköta ett arbete och fatta egna beslut. Men den behöver inte deklarera och kan inte dömas i domstol. Nu vill ett nytt forskningsprojekt bygga upp ett digitalt system som bland annat förhindrar risker och identifierar ansvar när AI används.

Det finns stora förhoppningar på hur AI ska kunna användas i framtiden.

Självkörande bilar ska minska antalet dödsolyckor, läkare ska kunna få hjälp att hitta bättre behandlingar åt sina patienter och koldioxidutsläpp ska kunna minskas med AI-stöd.

Men det finns också uppenbara problem.

Dolda AI-system byggs upp, där vi får intrycket att vi är i kontakt med en människa, men i själva verket får våra besked från en maskin.

Möjligheterna att kartlägga och kontrollera medborgare genom spårning av datatrafik, röstigenkänning och övervakningskameror är stora.

Och längst ut på skalan finns de autonoma dödliga vapensystem som flera länder misstänks forska kring. Där ska lärande maskiner på egen hand kunna fatta beslut om ett angrepp – och genomföra det.

Saknas lagar inom AI-området

Den tekniska utvecklingen går fort, medan just etiska regler och tydliga lagar är en bristvara inom AI-området idag.

– Redan nu är vi sent ute. Det är viktigt att börja arbeta. Juridiken klarar inte det här på egen hand, och det gör inte tekniken heller. Vi måste arbeta tillsammans, säger Cristina Trenta, docent i rättsvetenskap vid Örebro universitet.

Hon är en av de forskare från olika områden som nu tillsammans ska genomföra en första studie kring ett nytt system för en hållbar AI-utveckling. Under ledning av Stiftelsen Lightnet Foundation vill man bygga upp ett digitalt verktyg som ska hjälpa AI-projekt att följa god etik och olika sorters lagar och förordningar.

Hon är en av de forskare från olika områden som nu tillsammans ska genomföra en första studie kring ett nytt system för en hållbar AI-utveckling. Under ledning av Stiftelsen Lightnet Foundation vill man bygga upp ett digitalt verktyg som ska hjälpa AI-projekt att följa god etik och olika sorters lagar och förordningar.

AI måste användas etiskt

Sverige innovationsmyndighet Vinnova har nu anslagit strax under en halv miljon kronor till en första del av projektet.

– Å ena sidan finns det faror, å andra sidan möjligheter. Vi kan tjäna mänskligheten om vi använder AI till saker som är positiva för människor, som att upptäcka sjukdomar. Men om vi använder AI för att exploatera mänskligheten, så kan följderna bli mycket negativa. Det är orsaken till att vi måste agera – på ett etiskt sätt.

Frågan om hur den nya tekniken ska hanteras med lagar och regler är högaktuell och behandlas på många olika nivåer. FN-organisationen Unesco arbetar med frågan och så sent som förra året publicerade EU-kommissionens expertgrupp ett etiskt ramverk för AI.

Där konstateras att tillförlitlig AI helst ska uppfylla tre saker: den ska följa lagarna, vara etisk och vara tekniskt pålitlig.

Ska robotar deklarera?

Men själva lagarna är inte alltid anpassade efter den nya tekniken.

Det är inte självklart att det finns ett svar på frågan: vem blir ansvarig om den självkörande bussen orsakar en trafikolycka? Kan någon dömas för krigsbrott om en självlärande maskin beordrat dödandet av civilpersoner? Och vem bär ansvaret när ett program gett en människa fel medicinering?

– Algoritmer kan vara väldigt oförutsägbara, säger Cristina Trenta.

Men det finns också helt andra delar av lagboken som kan behöva anpassas.

Cristina Trenta, som tidigare har arbetat vid det italienska skatteverket och varit medlem i EU-kommissionens expertgrupp kring moms, ser också skattefrågan som en del av AI som behöver undersökas mer. När artificiell intelligens tar över jobb i fabrikerna har särskilda robotskatter börjat diskuteras. Och framöver, när ännu smartare AI kan göra helt andra saker, kommer då gränsen mellan människors och maskiners skyldigheter att börja suddas ut?

En egendomlig fråga blir då: Om vi människor måste deklarera, ska även artificiell intelligens göra det?

Avancerat verktyg för kontroll

Det nya projektet kommer fram till i sommar att undersöka möjligheterna för ett betydligt större projekt. Redan nu arbetar flera parter tillsammans, men man söker nu också ett större samarbete, gärna med både näringsliv och offentlig sektor.

Den prototyp till ett avancerat verktyg som man tänker konstruera ska ha kontroll över utvecklingen av ny AI. Från kodning till användning ska det gå att övervaka så att man följer de regler, förordningar och standarder som finns inom AI-området. En hjälp, så att ingenting missas eller går fel i processen.

Samtidigt pågår den större diskussionen runt om i världen: hur lagarna på AI-området ska formuleras. Redan idag finns en del internationella och nationella lagar som går att använda som grund, precis som FN:s deklaration om de mänskliga rättigheterna. Men AI-utvecklingen kommer att ställa mycket höga krav på de som formulerar nya lagar på området.

– Teknik ändras snabbt, lagar långsamt. Vi kan inte skriva en lag som är inaktuell redan när den börjar användas. Vi måste kunna se in i framtiden, säger Cristina Trenta.

Fakta: Så ska AI-processen kunna kontrolleras

Forskarna hoppas på sikt kunna utveckla ett verktyg som hjälper till att kontrollera nya AI-system.

Redan tidigt i processen ska verktyget se till att ingenting missas om äganderätt, ansvar och kvalitet.

Det övervakar så att regler, förordningar och standarder inom AI-området följs och ska också kunna hindra risker.

Det digitala systemet är tänkt att användas av både företag och offentliga organisationer.

Det verktyg som ska konstrueras i projektet ska ha engelska som huvudspråk, men lätt kunna översättas till andra språk.

Foto: Jesper Mattsson/Örebro universitet.